Aggiornamenti recenti Febbraio 12th, 2026 2:30 PM

News Recenti

- Transparency Center Initiative di Kaspersky Lab: cosa significa per l’Italia

- Effetto Domino: nel 2026 i fornitori sono le vulnerabilità più critiche

- Lummastealer risorge dalle ceneri: ancora una volta lo stop è momentaneo

- ZeroDayRAT: La Nuova Minaccia per Android e iOS

- L’arma dell’autenticità: come il cybercrimine sta piegando i servizi SaaS

- n8n: nuove vulnerabilità critiche aggirano le patch di dicembre

Prompt injection indiretta, Google migliora la sua strategia di sicurezza a più livelli per l’IA

Giu 24, 2025 Marina Londei Hacking, In evidenza, Minacce, News, RSS, Tecnologia 0

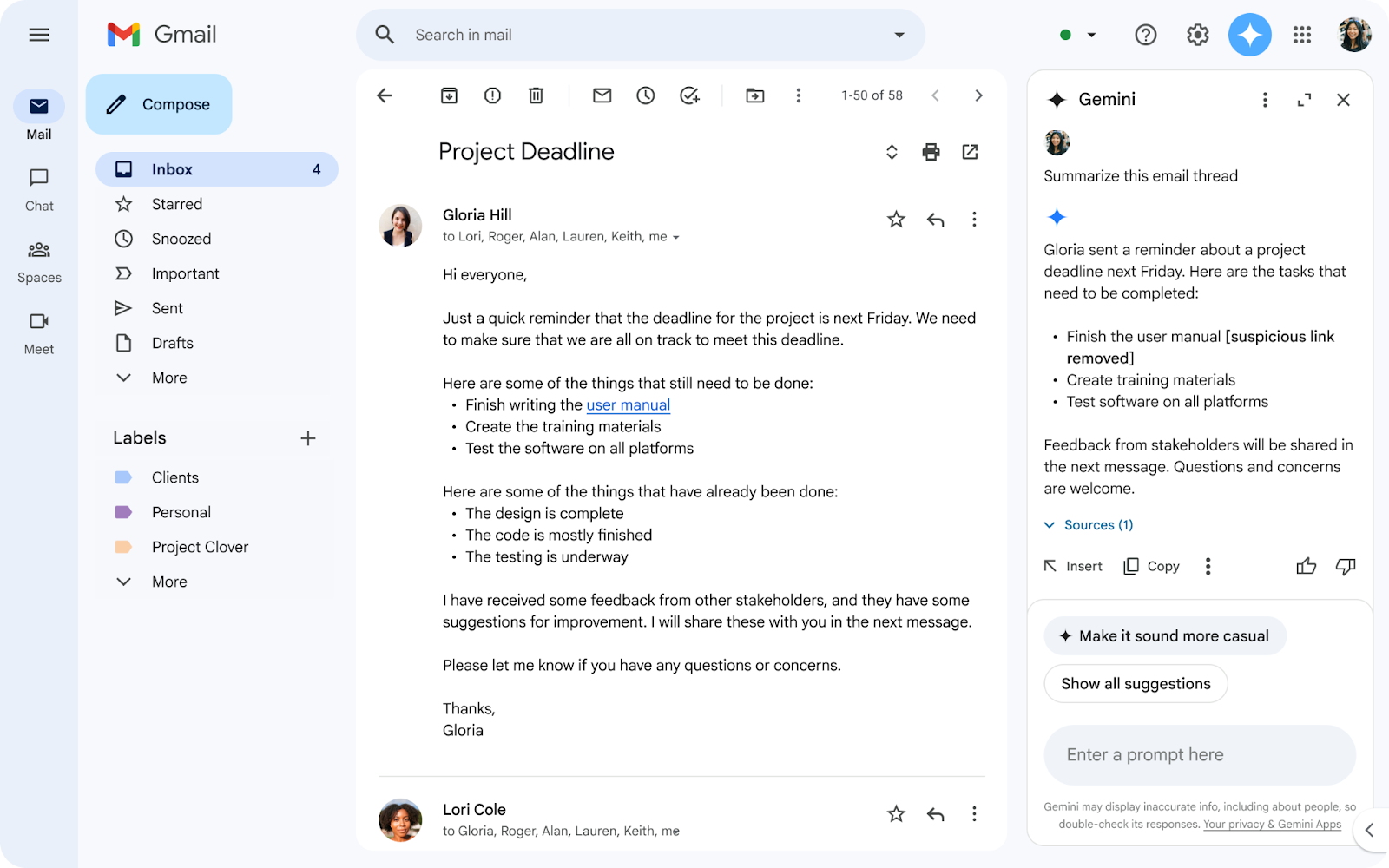

Tra le minacce più preoccupanti per i sistemi di intelligenza artificiale c’è la prompt injection indiretta, una tecnica che, a differenza di quella diretta, nasconde istruzioni malevole in sorgenti esterne, come inviti a riunioni, email o documenti. Per proteggersi da questa modalità di prompt injection, Google sta integrando nuove misure di sicurezza a più livelli nei propri strumenti.

La strategia “stratificata” del gigante tech prevede misure di sicurezza a ogni livello del ciclo di vita del prompt per rendere più difficile il lavoro dell’attaccante, in modo che “siano costretti ad affidarsi a metodi più facili da individuare o che richiedono più risorse” afferma il team GenAI Security di Google.

La difesa di Google contro l’iniezione indiretta di comandi comincia proprio dal prompt: la compagnia sta rilasciando dei modelli di machine learning in grado di individuare prompt e istruzioni malevole in diverse forme, comprese email e file. “Quando gli utenti cercano dati su Workspace con Gemini, i classificatori di contenuti filtrano i dati pericolosi che contengono istruzioni malevole” continua il team di sicurezza della compagnia.

Il secondo livello di protezione prevede un ulteriore controllo sul prompt che obbliga l’LLM a eseguire esclusivamente l’istruzione richiesta dall’utente, ignorando qualsiasi altra istruzione che potrebbe essere presente nel contenuto da caricare.

Il terzo livello di protezione agisce sugli URL delle immagini esterne, impedendo all’LLM di renderizzarle, e segnala qualsiasi URL sospetto senza includerlo nella risposta.

Credits: Google

Dal prossimo futuro Gemini richiederà, come ulteriore misura di protezione, un sistema di conferma utente per eseguire determinate azioni; “Per esempio, operazioni potenzialmente rischiose come cancellare un evento dal calendario scatenerebbe una richiesta di conferma per l’utente, aiutando così a prevenire l’esecuzione immediata e nascosta dell’operazione” chiarisce Google.

Infine, come ultima misura di sicurezza contro la prompt injection indiretta, Gemini notificherà all’utente l’eventuale presenza di allegati e contenuti malevoli, cancellando la risposta generata.

“La nostra strategia di sicurezza completa contro la prompt injection rafforza l’intero framework di sicurezza per Gemini“ afferma il team di Google. Oltre alle tecniche integrate nell’LLM, la compagnia ha annunciato nuovi test manuali e automatici di red teaming, l’uso di robusti standard di sicurezza come il Secure AI Framework (SAIF) e nuove partnership sia con ricercatori tramite il programma VRP (Vulnerability Reward Program) che con altre aziende tech grazie alla Coalition for Secure AI (CoSAI).

Articoli correlati

-

OpenSSL ha fixato 12 vulnerabilità...

OpenSSL ha fixato 12 vulnerabilità...Gen 29, 2026 0

-

Microsoft smantella RedVDS, rete...

Microsoft smantella RedVDS, rete...Gen 15, 2026 0

-

“Truman Show”: la truffa...

“Truman Show”: la truffa...Gen 14, 2026 0

-

Nuova ondata di attacchi GoBruteforcer,...

Nuova ondata di attacchi GoBruteforcer,...Gen 08, 2026 0

Altro in questa categoria

-

Effetto Domino: nel 2026 i fornitori...

Effetto Domino: nel 2026 i fornitori...Feb 12, 2026 0

-

Lummastealer risorge dalle ceneri:...

Lummastealer risorge dalle ceneri:...Feb 11, 2026 0

-

ZeroDayRAT: La Nuova Minaccia per...

ZeroDayRAT: La Nuova Minaccia per...Feb 10, 2026 0

-

L’arma dell’autenticità:...

L’arma dell’autenticità:...Feb 09, 2026 0

Last Week Security IT

Malware distruttivi ancora in auge

Approfondimenti

-

TrendAI: il 2026 sarà l’anno...

TrendAI: il 2026 sarà l’anno...Feb 06, 2026 0

L’intelligenza artificiale automatizzerà... -

Il 64% delle app di terze parti accede a dati sensibili...

Il 64% delle app di terze parti accede a dati sensibili...Gen 16, 2026 0

Dall’ultima ricerca di Reflectiz, “The State of... -

Microsoft smantella RedVDS, rete globale di...

Microsoft smantella RedVDS, rete globale di...Gen 15, 2026 0

Microsoft ha annunciato di aver smantellato RedVDS, una... -

Allarme password aziendali deboli: più del 40% è...

Allarme password aziendali deboli: più del 40% è...Gen 13, 2026 0

Gli utenti aziendali utilizzano ancora password deboli,... -

Nel 2026 sempre più attacchi autonomi AI-driven e...

Nel 2026 sempre più attacchi autonomi AI-driven e...Gen 05, 2026 0

Il mondo della cybersecurity si appresta a vivere un 2026...

Minacce recenti

ZeroDayRAT: La Nuova Minaccia per Android e iOS

TrendAI: il 2026 sarà l’anno dell’industrializzazione del cybercrime

Hugging Face sfruttato per distribuire un trojan Android

Off topic

-

L’IA generativa unifica le interfacce di gestione e...

L’IA generativa unifica le interfacce di gestione e...Gen 29, 2025 0

Con l’avvento dell’IA generativa... -

Cyberinsurance: misurare il rischio umano può...

Cyberinsurance: misurare il rischio umano può...Ott 09, 2024 0

Negli ultimi anni sempre più aziende stanno sottoscrivendo... -

Il machine learning di Kaspersky aumenta la capacità di...

Il machine learning di Kaspersky aumenta la capacità di...Ott 02, 2024 0

Grazie al machine learning, il Global Research and Analysis... -

I vertici aziendali non sono del tutto pronti alle nuove...

I vertici aziendali non sono del tutto pronti alle nuove...Set 30, 2024 0

Il 2024 è l’anno delle nuove normative di sicurezza:... -

Più della meta delle aziende geo-distribuite ha problemi...

Più della meta delle aziende geo-distribuite ha problemi...Mag 21, 2024 0

Una delle sfide principali delle aziende distribuite sul...

Post recenti

-

Effetto Domino: nel 2026 i fornitori sono le vulnerabilità...

Effetto Domino: nel 2026 i fornitori sono le vulnerabilità...Feb 12, 2026 0

Nell’ultimo High-Tech Crime Trends Report 2026 realizzato... -

Lummastealer risorge dalle ceneri: ancora una volta lo stop...

Lummastealer risorge dalle ceneri: ancora una volta lo stop...Feb 11, 2026 0

L’ecosistema del cybercrime dimostra ancora una volta... -

ZeroDayRAT: La Nuova Minaccia per Android e iOS

ZeroDayRAT: La Nuova Minaccia per Android e iOSFeb 10, 2026 0

I ricercatori di iVerify, un’azienda specializzata in... -

L’arma dell’autenticità: come il cybercrimine...

L’arma dell’autenticità: come il cybercrimine...Feb 09, 2026 0

Il panorama delle minacce informatiche è in continuo... -

n8n: nuove vulnerabilità critiche aggirano le patch di...

n8n: nuove vulnerabilità critiche aggirano le patch di...Feb 06, 2026 0

La sicurezza di n8n, una delle piattaforme open source...